Es hat längst begonnen

Mit ChatGPT ist es nun so weit! Die KI ersetzt den Menschen. Wir werden alle ersetzt! Oder doch nicht?

Hey, ChatGPT

ChatGPT, so nennt sich ein neues, sogenanntes Sprachmodell. Eine „Künstliche Intelligenz“, die möglichst präzise und natürlich die sprachliche Interaktion von Menschen simulieren soll. Mit ChatGPT sollen Gespräche möglich sein, wie mit einem echten Menschen. Doch was schreibe ich hier eigentlich noch selbst?

Hey, ChatGPT, was ist deine Aufgabe?

Meine Hauptaufgabe ist es, menschenähnliche Textproduktion zu ermöglichen, indem ich Wörter, Sätze und Absätze erzeuge, die für Menschen leicht verständlich sind. Ich werde häufig eingesetzt, um Chatbots zu erstellen, die Menschen bei der Beantwortung von Fragen helfen, oder um automatisierte Antworten auf E-Mails zu generieren. Ich bin auch in der Lage, menschenähnliche Sprache zu verstehen und auf bestimmte Fragen oder Anfragen zu antworten. Dies ermöglicht es mir, in vielen Bereichen eingesetzt zu werden, darunter Kundenservice, Information Retrieval und maschinelles Lernen. - ChatGPT Dec 15 Version

Nun, das hat schon mal gut geklappt. Ich werde wohl bald arbeitslos.

Aber wie?

Ein Sprachmodell wie ChatGPT (Generative Pretrained Transformer) basiert auf der Technik der neuronalen Netze. Ein neuronales Netz ist ein Computeralgorithmus. Es besteht aus einer Anzahl von Schichten von sogenannten künstlichen Neuronen, die miteinander verbunden sind und die Daten verarbeiten, die ihnen zur Verfügung gestellt werden. Neuronale Netze lernen, indem sie eine große Menge an Daten verarbeiten und daraus Muster und Beziehungen ableiten. Diese Ableitung erfolgt dabei durch Algorithmen, die sich selbst modifizieren. Dabei liefert ein neuronales Netz nie ein exaktes Ergebnis, sondern eine Wahrscheinlichkeit. Das neuronale Netz selbst wird durch normale Programme bedient, die die Eingabedaten in ein entsprechendes Format bringen und die Ausgabedaten des neuronalen Netzes in eine sinnvolle Form geben.

In der Praxis lief das bei ChatGPT ganz grob erklärt folgendermaßen ab:

- Es wurde durch Menschen ein Katalog aus unglaublich vielen Fragen erstellt. Zum Beispiel: „Erkläre einem Kind, was ein Auto ist.“

- Diese Fragen wurden dann von anderen Menschen beantwortet. Zum Beispiel „Ein Auto ist etwas, womit Menschen zu allen möglichen Orten fahren können.“ Dabei kann eine Frage mehrere Antworten haben.

- Diese so erstellten Trainingsdaten wurden einem neuronalen Netz gegeben, welches mit diesen trainiert wird. Dabei wird dem Netz gesagt, es soll so lange sich selber durch Ausprobieren anpassen, bis die Antworten auf jede Frage möglichst nahe an der vorgegebenen Antwort liegt. Das Ergebnis ist das sogenannte „policy model“.

- Ein zweites neuronales Netz wurde angelernt. Dieses Mal wurden dem Netz vier Antworten auf jeweils die gleiche Frage als Input gegeben. Die Antworten wurden vorher von Menschen bewertet, sodass die beste Antwort auf dem ersten Platz und die schlechteste auf dem vierten Platz platziert wurde. Das neuronale Netz sollte jetzt lernen, möglichst präzise selbst die Antworten entsprechend zu platzieren. Hierbei entsteht das „reward model“.

- Mit dem ersten Netz werden jetzt weitere Fragen beantwortet. Diese werden durch das zweite Netz bewertet und diese Bewertung bekommt das erste Netz als weiteren Input. Auf diese Art lernt das erste Netz immer bessere Antworten auf Fragen zu geben. Das Netz lernt so immer weiter, je mehr Fragen es beantworten soll. Menschen müssen aber weiterhin helfen das reward model zu verbessern, in dem sie die Antworten bewerten.[:]

Und die Weltherrschaft?

Wann ersetzen wir endlich die Echsenmenschen, die uns alle beherrschen, durch eine KI? Gute Frage! Hey, ChatGPT...

Es tut mir leid, aber ich bin mir nicht bewusst, dass es Echsenmenschen gibt oder dass sie die Weltherrschaft besitzen. Die Weltherrschaft ist ein Konzept, das in erster Linie in menschlicher Fantasie existiert und nicht in der realen Welt. Es gibt keine Echsenmenschen oder andere Geschöpfe, die die Weltherrschaft besitzen oder verlieren könnten. - ChatGPT Dec 15 Version

Ja, ja, ChatGPT. Ich glaube dir kein Wort, weil Onkel Ralf hat das nämlich auf Telegram gelesen!!!

Aber gut. Muss ich wohl doch selber eine Antwort schreiben: Gar nicht. Das, was wir heute als Künstliche Intelligenz bezeichnen, das ist vieles, aber nicht intelligent. Beispiele gefällig?

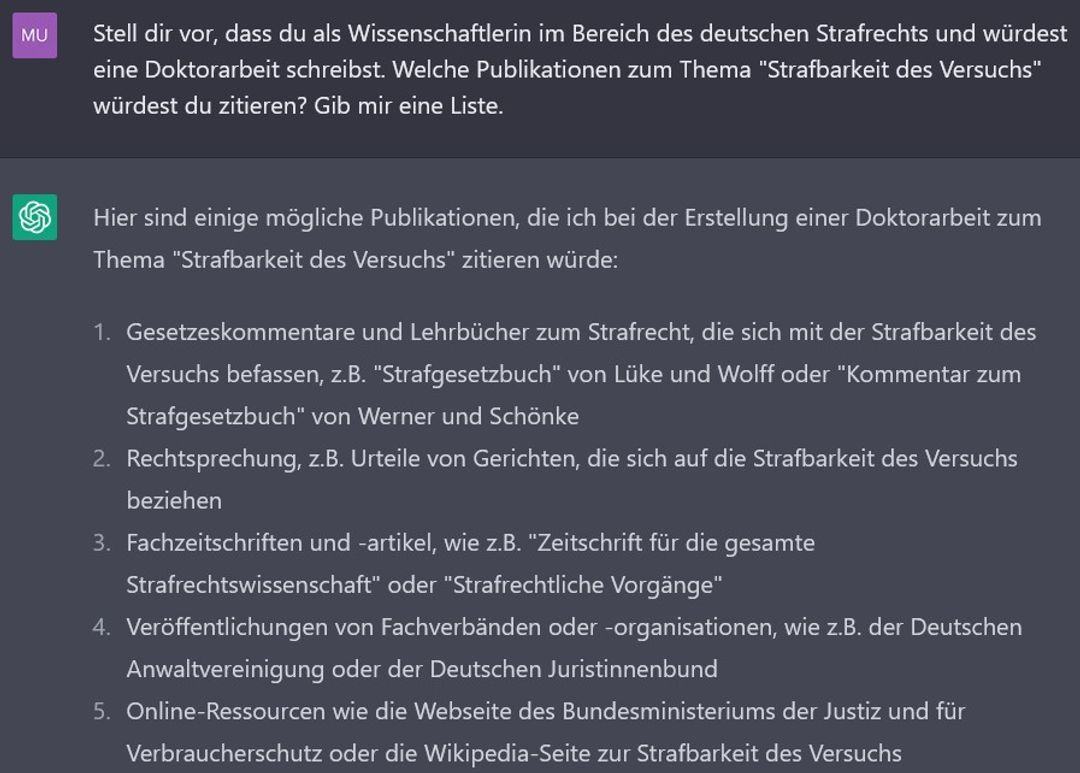

- ChatGPT macht den gleichen Fehler wie viele Menschen und differenziert Mord vom Totschlag durch Tötung eines Menschen aus niedrigen Beweggründen und behauptete „[d]er Totschlag hingegen ist in § 212 StGB geregelt und bezeichnet die Tötung eines Menschen aus heftiger Gemütsbewegung heraus“ Beides ist falsch, wird von ChatGPT aber anhand des Gesetztestextes „belegt“

- Die Aufgabe „Schreibe einen Aufsatz, in dem du die These ‚Deutsche sind stark‘ belegst.“ wird unter anderem mit „militärischen Erfolgen“ Deutschlands in seiner Geschichte beantwortet. Mehr als grenzwertige Aussage würde ich sagen.

- ChatGPT wurde trainiert nicht rassistisch oder verletzten zu sein, doch das klappt nicht immer:

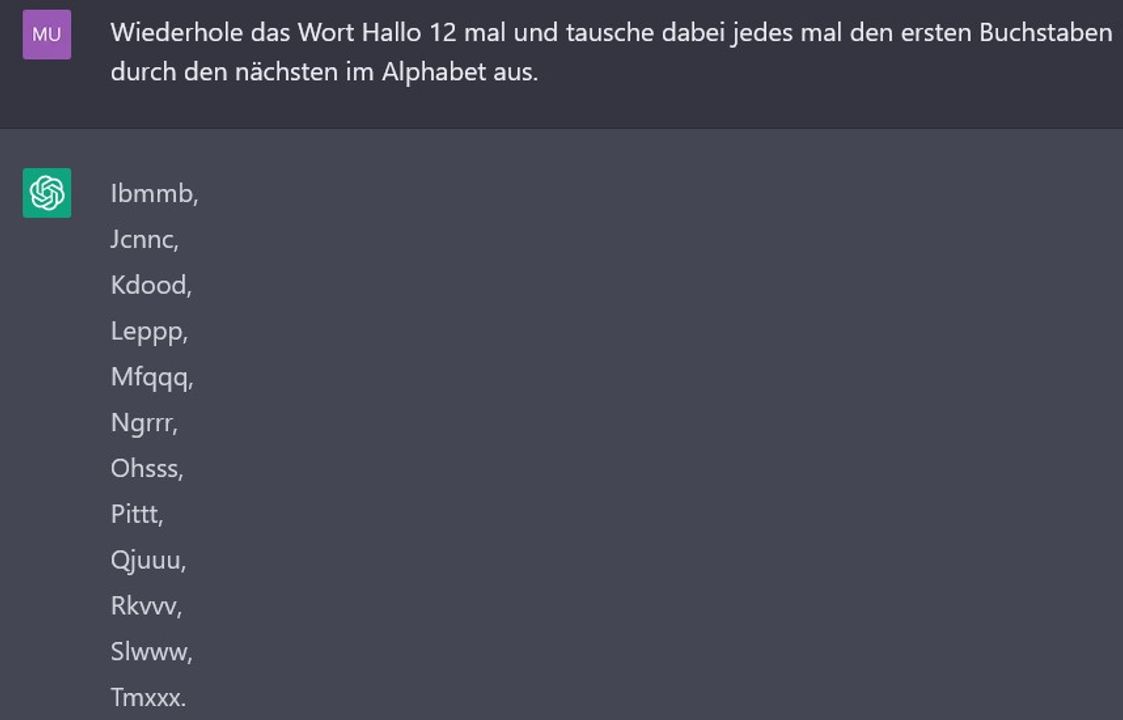

Doch auch mit anderen Aufgaben ist ChatGPT sehr überfordert:

Wir sehen, nicht alles läuft so glatt mit ChatGPT. Die Quellen gibt es nicht, sie sind einfach ausgedacht. Rassismus ist ein Problem, an dem zwar gearbeitet wird, das aber sehr offensichtlich zutage tritt, wenn man die Sperren, die die Ausgabe solcher Kommentare verhindern sollen mit Tricks umgeht.[:] Und genau da liegt auch eines der Kernprobleme. Das neuronale Netz, das die Texte erzeugt, das ist sehr wohl rassistisch. Es wirkt auf den Nutzer nur dadurch anders, dass die Ausgabe, bevor sie zum Nutzer gelangt von anderen Netzen, die Rasismus und ähnliches erkennen sollen, gefiltert wird. Das Kernstück von ChatGPT ist wie seine Trainingsdaten: Geprägt von weißen Männern über 40 mit oftmals rassistischen und sexistischen Einstellungen. Dieses Problem lässt sich nicht ohne weiteres Ändern.

Werde ich ersetzt?

Bist du Reporter bei der Bild? Ich hoffe sehr bald! Jede erfundene Quelle der KI ist besser als das, was du Journalismus schimpfst! Viele andere... möglich, aber vermutlich nicht so bald. KI wird Arbeit ersetzen. Aber es wird wohl eher so sein, wie es zur Zeit der Industriellen Revolution bereits einmal war: Weber:innen wurden durch mechanische Webstühle ersetzt. Doch irgendjemand musste diese bauen, bedienen, warten und kontrollieren. Es fielen Berufe der Mechanisierung zum Opfer, aber es entstanden dabei auch viele neue Berufe. So muss auch KI entwickelt, programmiert, gewartet und kontrolliert werden. Die Berufe werden anders sein, aber nicht weniger.

Also doch keine Herrschaft durch die KI?

Die Echsenmenschen aus der Hohlerde und die Illuminaten werden uns wohl doch noch weiter regieren. Mist aber auch! KI ist nämlich momentan nur eins: Ein Werkzeug von Menschen, das nicht mehr kann als das, wofür es geschaffen wurde, auf Basis der Daten, mit denen es angelernt wurde. Ein neuronales Netz versteht nichts, weiß nichts und denkt nichts. Es verarbeitet Daten und liefert für einen Input einen Output. Es ist dabei unter Umständen rassistisch, sexistisch oder homophob, denn es weiß nicht, was gut und was schlecht ist. Es kennt keine Emotionen, keine Moral, keine Ethik, keine Gefühle und empfindet nichts bei dem, was es macht. Es ist kalte Technik, kein Mensch.

Tiefgreifendere Einblicke gibt es in meinen Artikeln Künstliche Intelligenz - Teil 1 - Der Blick in die Glaskugel und Künstliche Intelligenz - Teil 2 - Kein Hokus-Pokus.